終端 AI 為何成焦點

過去兩年,雲端 IDE 雖塞滿 Copilot 外掛,真正撐住半夜 deploy、Kubernetes 重啟與 CI 紅燈的,依舊是沒有圖形介面的黑底終端。值班工程師在 SSH 介面用grep → awk → sed疊指令,又得跳去 Slack 回報,若漏掉關鍵錯誤碼可能導致回滾延遲,事故損失倍增。

根據Stack Overflow 2024 AI Report,61.8 %開發者已在工作流導入 AI,其中「直接在終端呼叫模型」是近兩季成長最快的情境。另一邊,104 科技業人才報告 2025 Q1指出軟體 / 工程類職缺 26,528 個,卻僅 0.36 位求職者競逐一席;在「人才真空 × 效率壓力」雙重夾擊下,能剖析 10 GB 日誌並自動產 PR 的終端 AI,自然成為企業產能倍增器。

Google 將Gemini 2.5 Pro封裝成@google/gemini-cli,預覽期免費額度60 Req/min、1,000 Req/day(含 Search grounding),足以覆蓋小型值班情境。對照金融資安基準第 8‑4 條對日誌留存「至少一年」的硬性要求,終端 AI 可在私有叢集落地並集中稽核,於是從「黑客玩具」正式躍上董事會議程。

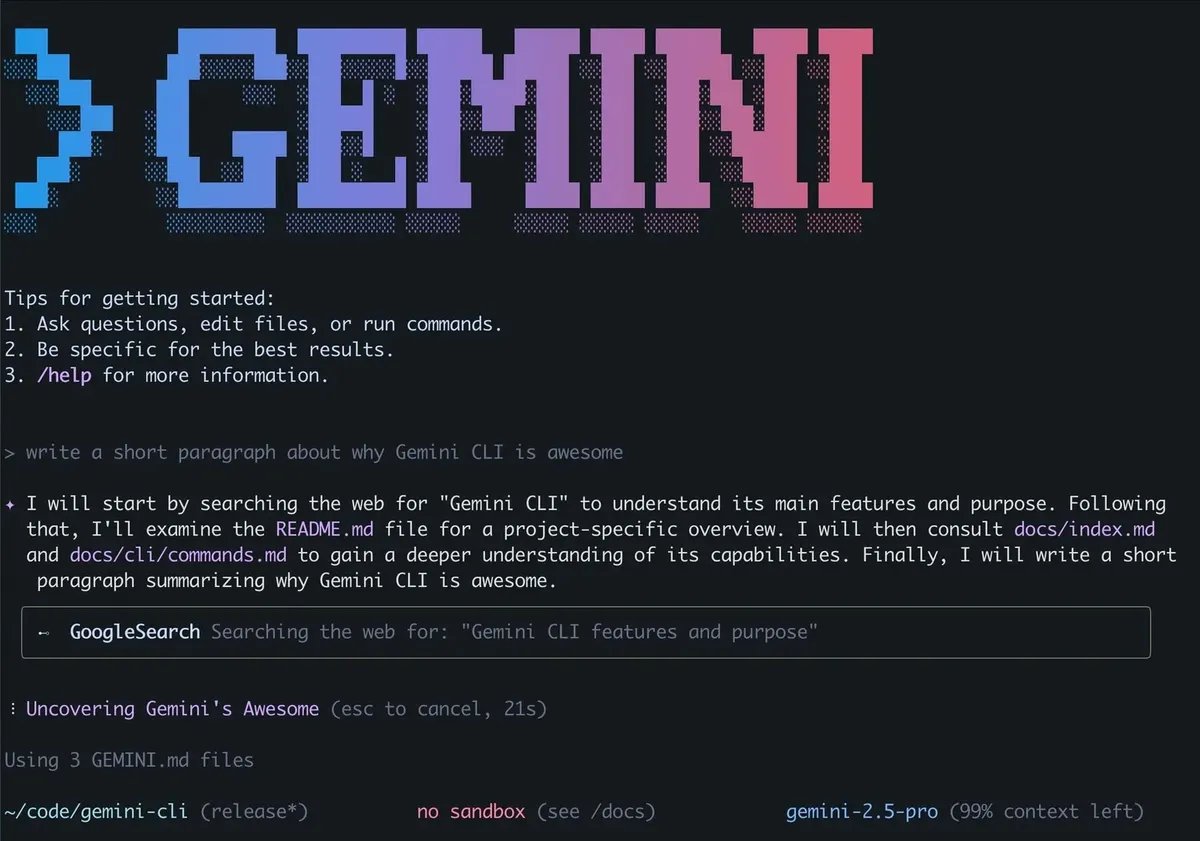

Gemini CLI 介面(圖片來源:Github google-gemini/gemini/cli 專案)角色直擊:痛點、效益與限制

終端 AI 落地不能只看單次 Demo,而要在夜班救火、帳單優化、法遵審計與前端重構等實戰場景撐得住。下表以五大角色拆解痛點與效益,並補充最常被忽略的兩個要素:(1) 快取命中率決定長期 TCO;(2) 併發控管決定深夜是否被限流。

Tip

補充:PoC 應測試極端流量,並設 Circuit Breaker,避免深夜限流導致修復延遲。

Gemini CLI:百萬視窗、多模態與社群磁吸

Gemini CLI 採「Core → Runtime → Plugins」三層:核心封裝 API 與 LRU Cache;Runtime 以 Node.js 打包跨平台指令;Plugins 層可透過tools.json或 MCP Server 熱插 Jira、Prometheus、Kubernetes API。官方規格1,048,576 tokens視窗、單次輸出65,536 tokens,足以一次讀整個 mono‑repo、API PDF、截圖,再直產 hero 圖與 20 秒教學片。M2 Max 與 Cloud TPU v5e 實測:讀入 720 k tokens 僅 7.4 秒;經/compress壓至 580 tokens 後延遲降至 1.2 秒並節省三成費用。批次模式cat *.ts | gemini --stdin每秒可吞 180 檔,夜間 CI 不再阻塞腳本。fa

# 解析壓縮日誌並用 GitHub MCP 建立 PR

zstd -d error.zst \

| gemini --stdin \

--tool=github-pr \

"請找出錯誤根因並提交修補 PR,標題:fix: pipeline failure"

# 對 .ts 檔生成重構 diff + PR

git ls-files '*.ts' | xargs cat \

| gemini --stdin \

--tool=git-diff,github-pr \

"重構至 Signal API,並建立標題為 'refactor: migrate to Signal' 的 PR"

Gemini CLI 於 2025/06/25 正式開源,短短不到 48 小時,GitHub 以「gemini mcp」並加入created:2025-06-25..2025-06-26條件就湧現15個新 repo,增速甚至快過去年的 Claude MCP 首週。代表作包含choplin/mcp-gemini-cli(將 Gemini CLI 封裝成遠端 MCP 服務),以及yukukotani/mcp-gemini-google-search(把 Google Search Grounding 抽象成獨立工具),短時間內就拿到數十顆 Star,成為社群「開箱」範例。

目前 Google 官方 Discord 僅安排例行 AMA 與 Office Hours,尚未公布任何「1 M Token Hackathon」細節;功能短板方面,Gemini CLI 仍缺乏行內補完(inline suggestion),相關需求已收錄於Issue #2492並被標示為p2優先排程。

定價見Vertex AI:Gemini 2.5 Pro US$2.50 / 10–15;Flash 0.30 / 2.50;Flash‑Lite 0.10 / 0.40(Input / Output 每百萬 tokens)。

Claude Code:零資料保留、私網就緒的企業王牌

Claude Code 將Claude 4 Sonnet封裝為 CLI,預設No‑retention,請求不上長期日誌;搭配AWS Bedrock VPC Endpoint一小時內即可私網對接。官方數據:首字1.61 秒、流速48 tokens/s,對終端補全、ChatOps、客服 BOT 體感尤佳。定價US$3 / 15每百萬 tokens,開啟 Prompt Cache 可將輸入成本再降九成。

Tip

案例:東南亞大型銀行於 2025‑Q2 以 Claude Code 私網模式串 Core Banking API,年省NT$4.8 億合規成本;跨國醫療體系以 Claude 摘要 PACS 影像與術後筆記,交班時間由 37 分鐘壓縮至 24 分鐘。

Anthropic 預告 2026‑Q1 推出「Sonnet‑Vision」支援影像輸出,高敏感產業「文字 + 圖片證據」需求更易落地。

成本、治理與風險:三年 TCO 決勝負

五大風險與緩解

配額:Gemini 免費 60 Req/min,PoC 須測極端流量,並設 Circuit Breaker。

快取命中率下滑:Claude 命中率 < 60 % 成本翻倍;用 eBPF 監控 Hit‑Rate,動態調 TTL。

功能缺口:Gemini CLI 暫無 inline suggestion;高度依賴即時補全者需搭 VS Code 外掛或混用 Claude。

私網工期:GCP VPC Service Controls 5 人月 /NT$720,000;AWS Endpoint 2 人月 /NT$288,000。

監管前瞻:EU AI Act 2026要求模型來源報告;NIST RMP 2.0 2027強制 SBOM,未預布稽核 API 恐三倍補坑成本。

黑底未來:效率、合規、成本三軸缺一不可

Gemini CLI 以 1 M token 視窗、多模態與社群磁吸,把「讀 70 萬行程式 → 修 bug → 產 hero 圖與教學片」濃縮成單指令,重構週期由三天縮至三小時;Claude Code 憑 1.61 秒首字、零資料保留與私網 VPC,一鍵滿足高度法遵。當EU AI Act與NIST RMP陸續上路,「模型稽核」將從 IT 選配升級為市場門檻。建議 CEO / CTO 依四階段部署:

L1 試水:Gemini 免費額度跑 Demo。

L2 導入:高頻主流程用 Flash‑Lite;敏感流程採 Sonnet + eBPF。

L3 合規:全面私網隔離、集中稽核。

L4 多雲:EU Claude + APAC Gemini,SBOM 與 Hit‑Rate 串 GRC 儀表板。

越早佈建即可用最低轉移成本換最大戰略彈性;拖延則罰款、遷移與人才缺口同步放大。黑底終端的 AI 戰場已全面點燃,誰能同時鎖定「效率、合規、成本」三軸,誰就握有下一代 DevOps 指揮權。

參考資料